Controllable Text-to-3D Generation via Surface-Aligned Gaussian Splatting, Zhiqi Li, arXiv2024

Overview

Text와 Condition Image(edge, depth, normal, scribble)를 입력을 가짐

Contribution

- Controllable fine grained text-to-multi-view image

- Multi-stage efficient 3D generation pipeline

- Gaussian-Mesh hybrid representation

- High-fidelity multi-view images and 3D assets

1) Controlnet과 MVDream으로 Multi view 이미지 생성

- Condition Image(edge, depth, normal, scribble)로 이미지를 편집하는 ControlNet

- Camera Pose로 multi view를 생성하는 MVDream

2) LGM으로 coarse한 3D Gaussian생성

- LGM : Large Multiview Gaussian Model for high-resolution 3d content creation

- Camera pose로 Plücker ray embedding를 획득. Image와 함께 U-Net 학습 → 학습된 모델 사용

3) 2D diffusion Loss와 SuGaR optimization으로 fine한 3D Gaussian생성

1. 2D diffusion모델을 기반으로 Loss를 계산.

- 2D diffusion모델은 DeepFloyd-IF를 사용

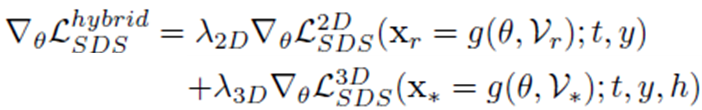

- Text y와 condition h로 2D SDS와 3D SDS를 계산.

- SDS Loss : 3DGS생성 이미지g와 Diffusion생성 이미지 확률분포가 유사해지도록, 3DGS parameter 업데이트

2. 3DGS로 depth와 alpha이미지를 랜더링.

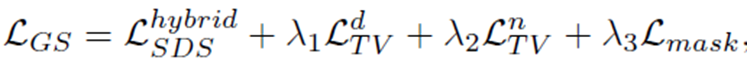

3. $\mathcal{L}_{TV}^{d} , \mathcal{L}_{TV}^{n}$ : depth를 미분하여 normal을 획득. depth와 normal을 regularization.

4. $\mathcal{L}_{mask}$ : Alpha이미지로 mask를 만들고 중간 과정?에서 생성되는 mask와 MSE를 계산

5. 계산된 Loss들로 Gaussian Splatting을 fine하게 update

4) Refinement를 통해 fine한 Mesh생성

1. SuGaR로 coarse한 Mesh획득

SuGaR에서 초기 opacity를 0.9로만 셋팅

2. mesh가 고정된 상태에서 아래 Loss로 Texture를 optimization

VSD는 SDS같은 역할. Texture 생성 성능이 좋음.

‘ 기호는 SuGaR로 fine하게 만들어진 mesh에 해당하는 depth, normal, mask

실험 결과

link에서 확인

Closing..

이번 리뷰는 개인적으로 여러 논문들을 보기 위해, 짧은 시간에 논문 파악하고 정리하는 연습을 목적으로 했습니다.

'3D-GS' 카테고리의 다른 글

| [논문 리뷰] GaussianPro (arXiv2024) : surface 퀄리티 향상 (2) | 2024.06.07 |

|---|---|

| [논문 리뷰] MVSGaussian (arXiv 2024) : Generalizable 모델 (0) | 2024.05.27 |

| [논문 리뷰] Style Gaussian (arXiv 2024) : 3DGS 스타일 변경 (0) | 2024.05.20 |

| [논문 리뷰] RadSplat (arXiv2024) : lightweight & 랜더링 속도 향상 (0) | 2024.04.30 |

| [논문 리뷰] InstantSplat (arXiv 2024) : Pose-free GS (2) | 2024.04.24 |

댓글